Open-Source vs. Closed AI: Who Should You Trust?

July 08, 2025

Theo: https://www.index.dev/blog/open-source-vs-closed-ai-guide

Bài được đưa lên Internet ngày: 08/07/2025

Niềm tin phụ thuộc vào mục tiêu của bạn: các mô hình đóng dẫn đầu về hiệu suất và khả năng kiểm soát, trong khi các mô hình mở chiến thắng về tính minh bạch và tính linh hoạt. Khám phá phương pháp nào mang lại sự tin cậy, bảo mật và hiệu suất tốt nhất.

AI đang biến đổi mọi ngành, nhưng việc tin tưởng vào đúng mô hình là rất quan trọng. Rủi ro rất cao: niềm tin, quản trị, hiệu suất, đạo đức và bảo mật đều đang bị đe dọa.

Các mô hình nguồn đóng (ví dụ: GPT-4, Claude) hiện đang dẫn đầu về hiệu suất thô và khả năng kiểm soát an toàn tập trung.

Các mô hình nguồn mở (ví dụ: Llama 2, Mistral) nổi bật về tính minh bạch, khả năng tùy chỉnh và sự kiểm duyệt của cộng đồng.

Các điểm chuẩn gần đây cho thấy trung bình nguồn đóng vẫn vượt trội, nhưng nguồn mở đang nhanh chóng thu hẹp khoảng cách. Các chuyên gia bảo mật cảnh báo các mô hình mở có nguy cơ bị tấn công dễ dàng hơn do trọng số công khai, tuy nhiên tính minh bạch của chúng giúp đẩy nhanh việc sửa lỗi, trong khi các mô hình đóng che giấu các lỗ hổng nhưng lại dựa vào sự tin tưởng của nhà cung cấp để vá lỗi.

Các khảo sát đối với các nhà phát triển củng cố cuộc tranh luận này: các kỹ sư trẻ và mới vào nghề đặc biệt coi trọng tính minh bạch. Trên thực tế, một khảo sát của StackOverflow năm 2025 cho thấy "niềm tin và khả năng học hỏi đóng vai trò trung tâm trong tương tác của các nhà phát triển trẻ với AI nguồn mở".

Các phòng thí nghiệm AI lớn cũng phản ánh sự phân chia này: OpenAI giữ các mô hình chủ lực của mình sau các khu vườn API khép kín để đảm bảo an toàn, trong khi các công ty như Meta và Anthropic đã mở mã nguồn nhiều mô hình. Ngay cả các nhà hoạch định chính sách cũng đang chú ý đến Đạo luật AI của EU, trong đó nêu rõ nguồn mở là hàng hóa công cộng (Public Good).

Trong bài viết này, chúng ta sẽ đi sâu vào cuộc tranh luận về AI mở và AI đóng. Chúng tôi sẽ giải thích ý nghĩa của từng phương pháp, ai ủng hộ phương pháp nào, tại sao sự tin cậy lại quan trọng, khi nào và ở đâu là phù hợp, và chúng so sánh như thế nào trên các mặt trận chính. Trong quá trình này, chúng tôi sẽ xem xét các tiêu chuẩn hiệu suất, sự đánh đổi về bảo mật, các cân nhắc về đạo đức, cũng như các tác động về quản trị và chính sách.

Cuối cùng, bạn sẽ có một cái nhìn rõ ràng, được chứng minh bằng bằng chứng về mô hình nào (và thực tiễn phát triển nào) tạo nên sự tin cậy trong bối cảnh nào.

Đối tượng tham gia: Nhà phát triển, Công ty và Cộng đồng

Ai đang định hình cuộc tranh luận này? Một bên là cộng đồng nguồn mở và các nhà phát triển độc lập. Cuộc tranh luận đặt cộng đồng nguồn mở (các nhà phát triển đằng sau PyTorch, TensorFlow, Hugging Face và vô số dự án GitHub) đối đầu với các công ty AI giữ bản quyền các mô hình mới nhất của họ để kiểm soát và bảo vệ quyền sở hữu trí tuệ (IP).

Những người ủng hộ công nghệ mở, 82% trong số họ đã đóng góp cho công nghệ nguồn mở, đề cao tính minh bạch, đánh giá ngang hàng và chia sẻ đổi mới. Trong khi đó, các doanh nghiệp và cơ quan quản lý dựa vào các giải pháp nguồn đóng (ví dụ: Azure OpenAI) để đáp ứng các yêu cầu tuân thủ nghiêm ngặt trong các lĩnh vực như chăm sóc sức khỏe và tài chính. Tại các hội nghị và trên các nền tảng chính sách, các chuyên gia tranh luận về "hợp tác mở so với kiểm soát đóng" như một sự phân chia cơ bản trong chiến lược AI.

Các chính phủ cũng tham gia: Đạo luật AI năm 2023 của EU nêu bật lợi ích kinh tế của các mô hình nền tảng nguồn mở trong khi vẫn nhấn mạnh tính an toàn, và các chính sách của Hoa Kỳ và Trung Quốc cũng tranh luận tương tự về tính mở so với kiểm soát. Tuy nhiên, những ranh giới này đang mờ dần khi Sam Altman của OpenAI đã lưu ý đến giới hạn của tính bảo mật hoàn toàn, và bản phát hành Llama 2 của Meta nhấn mạnh sự hợp tác trên toàn ngành.

AI nguồn mở và AI nguồn đóng là gì?

Chúng ta hiểu thế nào về "AI nguồn mở" so với "AI nguồn đóng"? Trên thực tế, các mô hình AI nguồn mở là những mô hình có mã, trọng số mô hình và dữ liệu đào tạo được công bố theo các giấy phép cho phép (MIT, Apache, GPL, v.v.) để mọi người có thể sử dụng và thay đổi. Hãy xem xét các dự án như LLaMA (Meta models) hoặc Stable Diffusion.

Chúng tồn tại trên các nền tảng như Hugging Face hoặc GitHub, và một cộng đồng tình nguyện viên có thể kiểm tra và cải thiện chúng.

Lời hứa chính: minh bạch hoàn toàn. Bạn có thể xem xét kiến trúc, dữ liệu đào tạo (nếu được công bố) và tinh chỉnh mô hình.

Ngược lại, các mô hình AI nguồn đóng là các hệ thống độc quyền, thường chỉ được cung cấp thông qua API hoặc giấy phép thương mại. Các công ty giữ trọng số và mã ở chế độ nền. Bạn có thể sử dụng chúng thông qua các dịch vụ hoặc sản phẩm đám mây (ví dụ: ChatGPT, Bard, Azure Cognitive Services). Hoạt động bên trong không nhìn thấy được và các điều khoản sử dụng được nhà cung cấp cố định. Sự đánh đổi nằm ở khả năng kiểm soát: các nhà cung cấp cho biết các mô hình đóng cho phép họ thực thi chính sách, sửa lỗi tập trung và kiếm tiền dễ dàng hơn.

Giữa hai thái cực này có các phương pháp tiếp cận kết hợp (lai):

Các mô hình phân tầng

Phát hành có kiểm soát

"Lõi mở" với các tiện ích bổ sung độc quyền

Một số hệ thống (như Llama 2) là mô hình mở với giấy phép hạn chế; một số khác là mô hình mở nhưng yêu cầu khóa API. Các mô hình lai này cố gắng cân bằng giữa tính mở và giám sát.

Nhãn này cũng mở rộng sang các công cụ: nhiều thư viện (PyTorch, Hugging Face Transformers, v.v.) là mã nguồn mở, cho phép AI hoạt động ngay cả với các mô hình đóng. Khi chúng ta nói về "AI mở so với AI đóng", chúng ta thực sự đang hỏi ai có thể xem hoặc thay đổi hoạt động bên trong của mô hình.

Về bản chất, AI nguồn mở = minh bạch và cộng đồng, trong khi AI nguồn đóng = kiểm soát độc quyền.

Mỗi bên tin tưởng các cơ chế khác nhau để đảm bảo AI đáng tin cậy và có đạo đức.

Khám phá 20 dự án nguồn mở trên Github có tác động lớn để đóng góp.

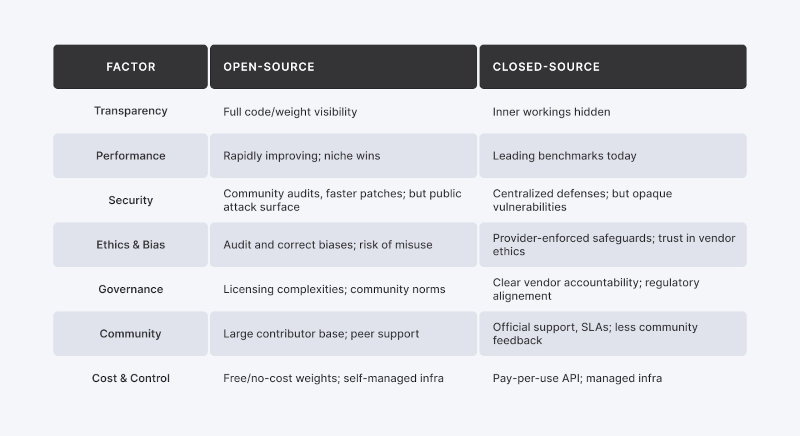

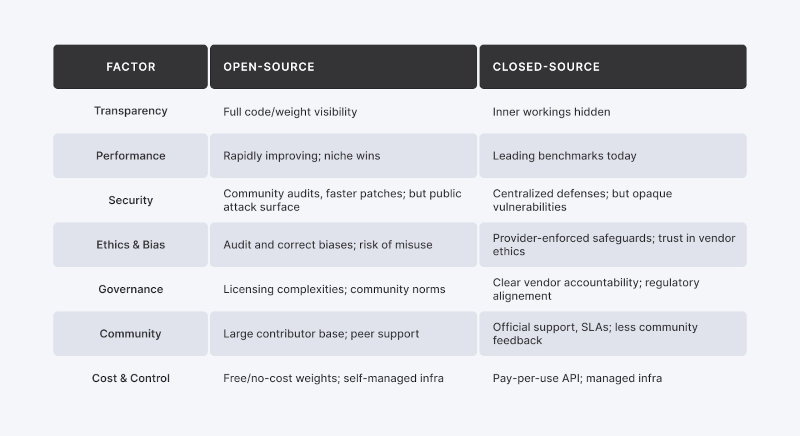

Ưu và nhược điểm của từng phương pháp

Tại sao cuộc tranh luận về niềm tin này lại gay gắt như vậy? Bởi vì các mô hình AI có thể có những tác động sâu sắc (một số không mong muốn) và việc xử lý đòi hỏi sự tự tin vào cách chúng hoạt động.

Dưới đây là các yếu tố chính:

Minh bạch so với Bí mật

Các mô hình mở cho phép chúng ta kiểm tra mã, kiểm tra nguồn dữ liệu và kiểm tra các sai lệch, xây dựng sự tin cậy thông qua khả năng hiển thị. Chính sự minh bạch đó làm lộ rõ các lỗ hổng (cửa hậu, rò rỉ dữ liệu). Các mô hình đóng giữ kín các thành phần bên trong, vì vậy chúng ta phải tin tưởng vào các tuyên bố về an toàn và giảm thiểu sai lệch của nhà cung cấp.

Bảo mật

Mã mở mời các chuyên gia bảo mật tìm và sửa lỗi, nhưng điều này cũng đồng nghĩa với việc cung cấp cho kẻ tấn công các bản thiết kế tương tự. Các mô hình đóng ẩn kiến trúc của chúng nhưng dựa vào một vài chuyên gia được chứng nhận và kiểm toán nội bộ. Các nhà cung cấp như OpenAI bổ sung các lớp (ví dụ: "tường lửa AI" kiểm tra lời nhắc) để cân bằng giữa tính minh bạch và khả năng bảo vệ.

Hiệu suất

Các LLM độc quyền (GPT-4, Claude) vẫn đạt điểm chuẩn cao nhất, vì vậy chúng tôi tin tưởng chúng cho các tác vụ có rủi ro cao. Nhưng các mô hình mở như Mistral và Llama-2-70b đang nhanh chóng thu hẹp khoảng cách, và trong các tình huống thích hợp, chúng thậm chí có thể vượt trội hơn các hệ thống đóng.

Đạo đức và Định kiến

Với các mô hình mở, chúng ta có thể xem xét dữ liệu đào tạo và tự áp dụng các bộ lọc đạo đức. Khả năng hiển thị này cũng giúp việc sử dụng sai mục đích (cho mục đích thông tin sai lệch hoặc ngôn từ kích động thù địch) dễ dàng hơn. Các mô hình đóng thực thi các quy tắc một cách tập trung, nhưng chúng ta phải tin tưởng vào các ưu tiên về đạo đức của nhà cung cấp. Một số đề xuất "mở theo tầng" hoặc kiểm toán công khai để đạt được kết quả tốt nhất.

Quản trị

Các cơ quan quản lý phải đối mặt với một thách thức: nếu ai đó có thể sửa đổi một mô hình mở, thì ai sẽ chịu trách nhiệm? Một số bài báo gần đây (ví dụ: Viện R Street) lập luận rằng các cơ quan quản lý phải thích nghi, vì trách nhiệm sản phẩm truyền thống không dễ dàng phù hợp. Đạo luật AI của EU thừa nhận những lợi ích của mã nguồn mở nhưng yêu cầu các rào cản an toàn, trong khi các chính sách của Hoa Kỳ tập trung vào trách nhiệm của nhà cung cấp bất kể trạng thái mã nguồn. Cho dù thông qua các chuẩn mực cộng đồng hay sự tuân thủ của doanh nghiệp, việc quản trị đáng tin cậy là điều cần thiết.

Cộng đồng và Hỗ trợ

Các cộng đồng mã nguồn mở (diễn đàn, GitHub) cung cấp sự hỗ trợ nhanh chóng từ đồng nghiệp và sự đổi mới tập thể khi 57% nhà phát triển thích đóng góp cho các dự án mở. Hệ sinh thái đóng cung cấp các Thỏa thuận Cấp độ Dịch vụ (SLA) chính thức và hỗ trợ từ nhà cung cấp. Các nền tảng như Index.dev kết nối cả hai bằng cách kiểm tra nhân tài, vì vậy chúng ta biết rằng những người có kỹ năng và đáng tin cậy đứng sau mọi hệ thống AI.

Tóm lại, AI nguồn mở có xu hướng chiếm được lòng tin thông qua tính minh bạch, sự hợp tác và giám sát cộng đồng, với cái giá phải trả là dễ bị tổn thương và (cho đến gần đây) hiệu suất thô yếu hơn.

AI nguồn đóng chiếm được lòng tin thông qua kiểm soát tập trung, các biện pháp bảo mật và danh tiếng thương hiệu, nhưng nó đòi hỏi người dùng phải tin tưởng vào các quy trình chưa được biết đến. Cả hai phương pháp đều có ưu và nhược điểm, và các giải pháp thực tế thường kết hợp các yếu tố của từng phương pháp.

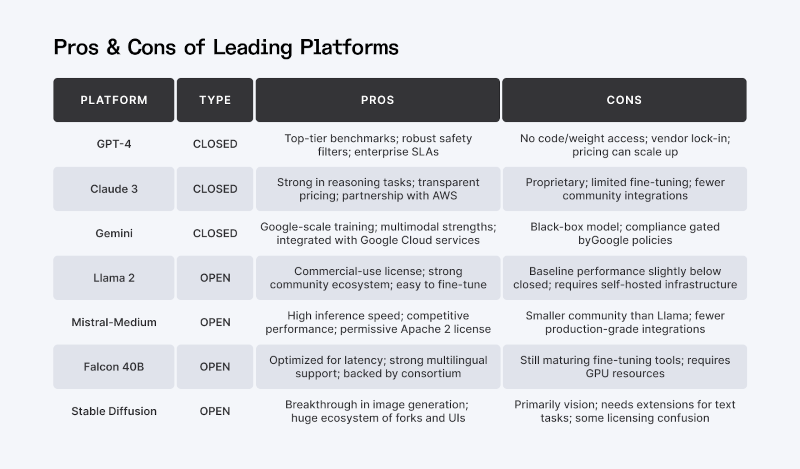

Hiệu suất và Độ tin cậy: So sánh

Hãy cùng tìm hiểu sâu hơn về hiệu suất, một khía cạnh quan trọng tạo nên sự tin tưởng của nhiều người dùng. Nếu một chatbot AI đưa ra những câu trả lời hữu ích một cách đáng tin cậy, người dùng sẽ tin tưởng nó hơn. Các điểm chuẩn gần đây cho thấy rõ bối cảnh hiện tại:

Các công ty dẫn đầu hiện tại:

Các LLM độc quyền như GPT-4, Gemini của Google và Claude dẫn đầu các điểm chuẩn. Trong các so sánh về "điểm ELO", các mô hình đóng luôn vượt trội hơn các mô hình mở, với các mô hình mở tập trung ở mức thấp hơn.

Lợi ích từ mô hình mở:

Khoảng cách đang dần thu hẹp. Các mô hình mở như Qwen-72B, Llama-2-70b-chat và Mistral-Medium hiện đang cạnh tranh với các hệ thống đóng. Các công ty công nghệ lớn thậm chí còn đang mở nguồn nhiều hơn cho dòng sản phẩm của mình với Gemma của Google và Phi-4 của Microsoft có các biến thể mở, và Llama 2 của Meta đã tìm thấy sức hút thương mại vào năm 2023.

Vượt ra ngoài Chatbot:

Các mô hình mở không chỉ bắt kịp trong văn bản; thay vào đó, họ đã dẫn đầu những đột phá trong các tác vụ hình ảnh (Stable Diffusion) và thị giác (CLIP), tăng cường sự tự tin vào các phương pháp tiếp cận mở.

Giải pháp lai:

Nhiều nhóm kết hợp các dịch vụ đóng (ví dụ: GPT-4) cho các khối lượng công việc cốt lõi với các mô hình mở nhỏ hơn để thử nghiệm, đạt được cả tính ổn định và tính linh hoạt.

Trong thực tế:

Đối với các tác vụ quan trọng (như tóm tắt nâng cao hoặc mã hóa), một mô hình đóng hàng đầu có thể là an toàn nhất hiện nay. Nếu bạn cần tùy chỉnh hoặc hiểu sâu về hành vi của mô hình, các mô hình mở hiện mang lại hiệu suất cạnh tranh với khả năng tinh chỉnh. Các khảo sát gần đây thậm chí còn cho thấy rằng "các mô hình nguồn mở nhỏ có thể theo kịp các mô hình nguồn đóng" trong nhiều tác vụ.

Niềm tin dựa trên sự giám sát pháp lý. Đạo luật AI của EU phân loại tất cả các mô hình nền tảng - mở hoặc đóng - theo mức độ rủi ro, đánh giá lợi ích kinh tế của nguồn mở đồng thời đảm bảo an toàn. Chính sách của Hoa Kỳ (Sắc lệnh Hành pháp AI năm 2023 của Biden) tập trung vào các phương pháp hay nhất của nhà cung cấp hơn là các nhãn mở. Tại Châu Âu, người dùng mô hình đóng phải chứng minh sự tuân thủ; người sửa đổi mô hình mở có thể phải chịu các nghĩa vụ quản trị dữ liệu.

Trên thực tế, điều này có nghĩa là các tổ chức phải tuân thủ các tiêu chuẩn minh bạch theo cả hai cách. Ví dụ: nếu bạn sử dụng mô hình đóng ở Châu Âu cho một ứng dụng có rủi ro cao, bạn phải chứng minh sự tuân thủ (ngay cả khi bạn không thể xem mã). Nếu bạn sửa đổi một mô hình mở, bạn có thể phải đối mặt với các nghĩa vụ pháp lý mới (như quản trị dữ liệu) như báo cáo của R Street đã cảnh báo.

Các phương pháp hay nhất

Hầu hết các chuyên gia ủng hộ phương pháp kết hợp: áp dụng các biện pháp kiểm soát truy cập hoặc cấp phép cho các mô hình nguồn mở mạnh mẽ ("lõi mở") và liên quan đến việc thiết lập chuẩn mực cộng đồng (ví dụ: hướng dẫn "phát hành có trách nhiệm"), trong khi các nhà cung cấp nguồn đóng công bố các tuyên bố về đạo đức và hợp tác về các tiêu chuẩn. Việc ra quyết định linh hoạt (quyền truy cập theo tầng cho các hệ thống mở và quy trình kiểm toán mở cho các hệ thống đóng) đảm bảo tính trách nhiệm.

Tìm hiểu cách bắt đầu Vibe Coding với AI (một cách dễ dàng).

Bảo mật: Lỗ hổng và Phòng thủ

Bảo mật củng cố niềm tin. Cả hệ thống AI mở và đóng đều phải đối mặt với các cuộc tấn công, nhưng phương pháp khác nhau:

Tấn công mô hình mở

Mã và trọng số công khai khiến các cuộc tấn công xâm phạm quyền riêng tư và đầu độc dễ dàng hơn. Các mối đe dọa như đảo ngược mô hình, suy luận thành viên, rò rỉ dữ liệu và cửa hậu là có thật, nhưng các bản vá do cộng đồng thúc đẩy và tinh chỉnh đồng nghĩa với việc các bản sửa lỗi có thể được triển khai nhanh chóng khi phát hiện ra lỗ hổng.

Tấn công mô hình đóng

Các nội dung ẩn bên trong yêu cầu bạn phải tin tưởng vào quá trình kiểm tra bảo mật của nhà cung cấp, nhưng lỗi vẫn có thể lọt qua. Ví dụ: một mô hình nền tảng nguồn mở đã từng bị lộ khóa API và nhật ký trò chuyện do lỗi. Để phòng thủ, nhiều nhà cung cấp triển khai tường lửa AI quét đầu vào và lọc đầu ra, đồng thời thực thi các lệnh gọi API đã xác thực bằng cách ghi nhật ký và giới hạn tốc độ.

Rủi ro nội bộ và chuỗi cung ứng

Các dự án nguồn mở phải bảo vệ chống lại các mã độc hại, trong khi các hệ thống đóng phải bảo mật đường ống dữ liệu và phần cứng của chúng. Các biện pháp phòng thủ phổ biến bao gồm kiểm toán mã chính thức, phần cứng được chứng nhận và môi trường tính toán đáng tin cậy.

Tìm kiếm sự cân bằng

Các chuyên gia khuyến nghị kết hợp tính minh bạch và kiểm soát: áp dụng thẻ mẫu và đánh giá bảo mật thường xuyên, công bố báo cáo minh bạch và thuê các "nhóm đỏ" của bên thứ ba để thăm dò cả mô hình mở và đóng. Cách tiếp cận này kết hợp sự giám sát của cộng đồng với các biện pháp bảo vệ cấp doanh nghiệp.

Quan điểm và Nền tảng của Nhà phát triển

Niềm tin của các nhà phát triển phụ thuộc vào cộng đồng và công cụ. Nhiều kỹ sư ưa chuộng mã nguồn mở để học hỏi và thử nghiệm trên các nền tảng như GitHub và Hugging Face. Các trang web tuyển dụng như Index.dev kiểm tra và tuyển chọn các nhà phát triển lành nghề, đảm bảo những người đóng góp đáng tin cậy cho bất kỳ dự án nào, dù mở hay đóng. Sự tin tưởng vào người viết mã AI cũng quan trọng như chính mã nguồn.

Sự tham gia của cộng đồng thúc đẩy niềm tin: các công ty phát hành mô hình mở hợp tác với các diễn đàn nhà phát triển để nhận phản hồi. Theo khảo sát StackOverflow đã đề cập trước đó, 57% nhà phát triển ưa chuộng các dự án mã nguồn mở trong khi chỉ 30% ủng hộ công nghệ độc quyền. Tư duy ủng hộ mở này dẫn đến việc báo cáo vấn đề, cải tiến và chia sẻ kiến thức nhiều hơn.

Các doanh nghiệp e ngại mô hình mở hơn các lỗ hổng quản trị giờ đây có thể lựa chọn các dự án mở cung cấp hỗ trợ hoặc chứng nhận cao cấp. Trong khi đó, các nhà cung cấp mô hình đóng cũng đang thu hút các nhà phát triển - ví dụ như Microsoft đã mở mã nguồn một số phần của dịch vụ nhận thức.

Điểm chính:

Niềm tin không chỉ nằm ở nhãn mở hay đóng. Nó phát triển thông qua lộ trình minh bạch, mô hình được chứng nhận và nhân tài được kiểm tra từ các mạng lưới đáng tin cậy.

Vậy, bạn nên quyết định mô hình nào đáng tin cậy? Hãy cân nhắc:

Mẹo thiết thực:

Ai nên quyết định?

Đội ngũ kỹ thuật và pháp lý của bạn, với sự đóng góp từ các chuyên viên đạo đức và có thể là các nhà lãnh đạo cộng đồng các nhà phát triển.

Cần làm gì?

Đánh giá các mô hình thông qua các điểm chuẩn (như trong các bài báo gần đây), thực hiện các bài kiểm tra bảo mật và kiểm tra giấy phép.

Sử dụng từng mô hình ở đâu/khi nào?

Sử dụng mô hình mở cho nghiên cứu, công cụ nội bộ và các sản phẩm do cộng đồng thúc đẩy; sử dụng mô hình đóng cho các hệ thống sản xuất quan trọng, nơi các đảm bảo là tối quan trọng.

Tại sao nên tin tưởng mô hình này hơn mô hình kia?

Điều này phụ thuộc vào khả năng chịu rủi ro và các giá trị của bạn: tính mở so với kiểm soát.

Làm thế nào để xây dựng niềm tin?

Kiểm tra kỹ lưỡng các nhà phát triển của bạn (xem các nền tảng như Index.dev), áp dụng các phương pháp hay nhất (kiểm toán thường xuyên, "nhóm đỏ", tài liệu) và cập nhật chính sách (ví dụ: tuân thủ Đạo luật AI của EU).

Kết luận: Cân bằng Niềm tin trong Thế giới AI

Việc lựa chọn giữa các mô hình AI mở và đóng không phải là chọn phe, mà là hiểu rõ nhu cầu của bạn.

Tính minh bạch, hiệu suất, bảo mật và cộng đồng đều là những yếu tố tạo nên niềm tin, và sự cân bằng phù hợp thường nằm ở việc kết hợp cả hai. Nguồn mở mang lại sự linh hoạt và khả năng cộng tác, trong khi nguồn đóng mang lại sự tinh tế và trách nhiệm giải trình.

Đối với nhiều tổ chức, chiến lược kết hợp là hợp lý nhất: tận dụng các mô hình mở để đổi mới và tinh chỉnh, đồng thời triển khai các mô hình đóng khi độ tin cậy là yếu tố then chốt. Điều quan trọng nhất là cách thức bạn triển khai, quản lý và bố trí nhân sự cho các nỗ lực AI của mình.

Các nền tảng như Index.dev đóng một vai trò quan trọng trong phương trình này, kết nối các doanh nghiệp với các nhà phát triển được kiểm tra kỹ lưỡng, những người mang đến cả chuyên môn và trách nhiệm giải trình. Bởi vì cuối cùng, AI đáng tin cậy không chỉ nằm ở mã nguồn. Nó nằm ở những con người đằng sau nó và các hoạt động thực hành xung quanh nó.

Niềm tin không phải là một nút bấm, nó là một hệ thống. Hãy xây dựng nó một cách có chủ đích.

Đối với các nhà phát triển:

Kết nối với các đội ngũ toàn cầu hàng đầu đang xây dựng các dự án AI có đạo đức. Làm việc từ xa, linh hoạt và bổ ích, chỉ có trên Index.dev.

Đối với khách hàng:

Cần các giải pháp AI đáng tin cậy? Thuê các nhà phát triển được kiểm tra từ Index.dev để xây dựng các hệ thống AI an toàn và đáng tin cậy cho doanh nghiệp của bạn.

Tác giả: admin

Ý kiến bạn đọc

Những tin mới hơn

Những tin cũ hơn

Trang Web này được thành lập theo Quyết định số 142/QĐ-HH do Chủ tịch Hiệp hội các trường đại học, cao đẳng Việt Nam – AVU&C (Association of Vietnam Universities and Colleges), GS.TS. Trần Hồng Quân ký ngày 16/09/2019, ngay trước thềm của Hội thảo ‘Xây dựng và khai thác tài nguyên giáo dục mở’ do 5...

Hướng dẫn kỹ thuật lời nhắc. Kỹ thuật viết lời nhắc

Hướng dẫn kỹ thuật lời nhắc. Kỹ thuật viết lời nhắc

Hướng dẫn kỹ thuật lời nhắc. Giới thiệu. Ví dụ về lời nhắc

Hướng dẫn kỹ thuật lời nhắc. Giới thiệu. Ví dụ về lời nhắc

Hướng dẫn kỹ thuật lời nhắc. Giới thiệu. Mẹo chung cho việc thiết kế lời nhắc

Hướng dẫn kỹ thuật lời nhắc. Giới thiệu. Mẹo chung cho việc thiết kế lời nhắc

Hướng dẫn kỹ thuật lời nhắc. Giới thiệu. Các thành phần của lời nhắc

Hướng dẫn kỹ thuật lời nhắc. Giới thiệu. Các thành phần của lời nhắc

Tài nguyên Giáo dục Mở trong kỷ nguyên AI

Tài nguyên Giáo dục Mở trong kỷ nguyên AI

Hướng dẫn kỹ thuật lời nhắc. Giới thiệu. Cơ bản về lời nhắc

Hướng dẫn kỹ thuật lời nhắc. Giới thiệu. Cơ bản về lời nhắc

Hướng dẫn kỹ thuật lời nhắc. Giới thiệu. Thiết lập LLM

Hướng dẫn kỹ thuật lời nhắc. Giới thiệu. Thiết lập LLM

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm)

50 công cụ AI tốt nhất cho năm 2025 (Đã thử và kiểm nghiệm)

Các bài toàn văn cho tới hết năm 2024

Các bài toàn văn cho tới hết năm 2024

Các bài trình chiếu trong năm 2024

Các bài trình chiếu trong năm 2024

Các lớp tập huấn thực hành ‘Khai thác tài nguyên giáo dục mở’ tới hết năm 2024

Các lớp tập huấn thực hành ‘Khai thác tài nguyên giáo dục mở’ tới hết năm 2024

Các tài liệu dịch sang tiếng Việt tới hết năm 2024

Các tài liệu dịch sang tiếng Việt tới hết năm 2024

Tập huấn thực hành ‘Khai thác tài nguyên giáo dục mở’ cho giáo viên phổ thông, bao gồm cả giáo viên tiểu học và mầm non tới hết năm 2024

Tập huấn thực hành ‘Khai thác tài nguyên giáo dục mở’ cho giáo viên phổ thông, bao gồm cả giáo viên tiểu học và mầm non tới hết năm 2024

Bộ các tài liệu hướng dẫn của UNESCO cho các chính phủ và cơ sở để triển khai Khuyến nghị Tài nguyên Giáo dục Mở

Bộ các tài liệu hướng dẫn của UNESCO cho các chính phủ và cơ sở để triển khai Khuyến nghị Tài nguyên Giáo dục Mở

Hướng dẫn thực hành về Giáo dục Mở cho các học giả: Hiện đại hóa giáo dục đại học thông qua các thực hành Giáo dục Mở (dựa trên Khung OpenEdu)

Hướng dẫn thực hành về Giáo dục Mở cho các học giả: Hiện đại hóa giáo dục đại học thông qua các thực hành Giáo dục Mở (dựa trên Khung OpenEdu)

Chứng chỉ Creative Commons cho các nhà giáo dục, thủ thư hàn lâm, và văn hóa mở

Chứng chỉ Creative Commons cho các nhà giáo dục, thủ thư hàn lâm, và văn hóa mở

Các mô hình bền vững Tài nguyên Giáo dục Mở (TNGDM) - Tổng hợp

Các mô hình bền vững Tài nguyên Giáo dục Mở (TNGDM) - Tổng hợp

ORCID - Quy trình làm việc

ORCID - Quy trình làm việc

Tổng hợp các bài của Nhóm các Nhà cấp vốn Nghiên cứu Mở (ORFG) đã được dịch sang tiếng Việt

Tổng hợp các bài của Nhóm các Nhà cấp vốn Nghiên cứu Mở (ORFG) đã được dịch sang tiếng Việt

Tổng hợp các bài của Liên minh S (cOAlition S) đã được dịch sang tiếng Việt

Tổng hợp các bài của Liên minh S (cOAlition S) đã được dịch sang tiếng Việt

Europeana - mô hình mẫu về hệ thống liên thông, Dữ liệu Mở (Liên kết) và dữ liệu FAIR của OpenGLAM/Văn hóa Mở

Europeana - mô hình mẫu về hệ thống liên thông, Dữ liệu Mở (Liên kết) và dữ liệu FAIR của OpenGLAM/Văn hóa Mở

Năm Khoa học Mở & Chuyển đổi sang Khoa học Mở - Tổng hợp các bài liên quan

Năm Khoa học Mở & Chuyển đổi sang Khoa học Mở - Tổng hợp các bài liên quan

‘Bộ công cụ Khoa học Mở của UNESCO’ - Các bản dịch sang tiếng Việt

‘Bộ công cụ Khoa học Mở của UNESCO’ - Các bản dịch sang tiếng Việt

Định nghĩa các khái niệm liên quan tới Khoa học Mở

Định nghĩa các khái niệm liên quan tới Khoa học Mở

‘Digcomp 2.2: Khung năng lực số cho công dân - với các ví dụ mới về kiến thức, kỹ năng và thái độ’, EC xuất bản năm 2022

‘Digcomp 2.2: Khung năng lực số cho công dân - với các ví dụ mới về kiến thức, kỹ năng và thái độ’, EC xuất bản năm 2022

‘ĐÁNH DẤU KHÓA HỌC MỞ VÀ KHAM ĐƯỢC: CÁC THỰC HÀNH TỐT NHẤT VÀ CÁC TRƯỜNG HỢP ĐIỂN HÌNH’ - VÀI THÔNG TIN HỮU ÍCH

‘ĐÁNH DẤU KHÓA HỌC MỞ VÀ KHAM ĐƯỢC: CÁC THỰC HÀNH TỐT NHẤT VÀ CÁC TRƯỜNG HỢP ĐIỂN HÌNH’ - VÀI THÔNG TIN HỮU ÍCH

Khóa học cơ bản về Dữ liệu Mở trong chương trình học tập điện tử trên Cổng Dữ liệu châu Âu

Khóa học cơ bản về Dữ liệu Mở trong chương trình học tập điện tử trên Cổng Dữ liệu châu Âu